데이터 분석 주제 발굴 연습

1. (1) 데이터안심구역 접속 > (2) 첫화면에서 마우스 스크롤 (아래로) > (3) 제공 데이터 조회

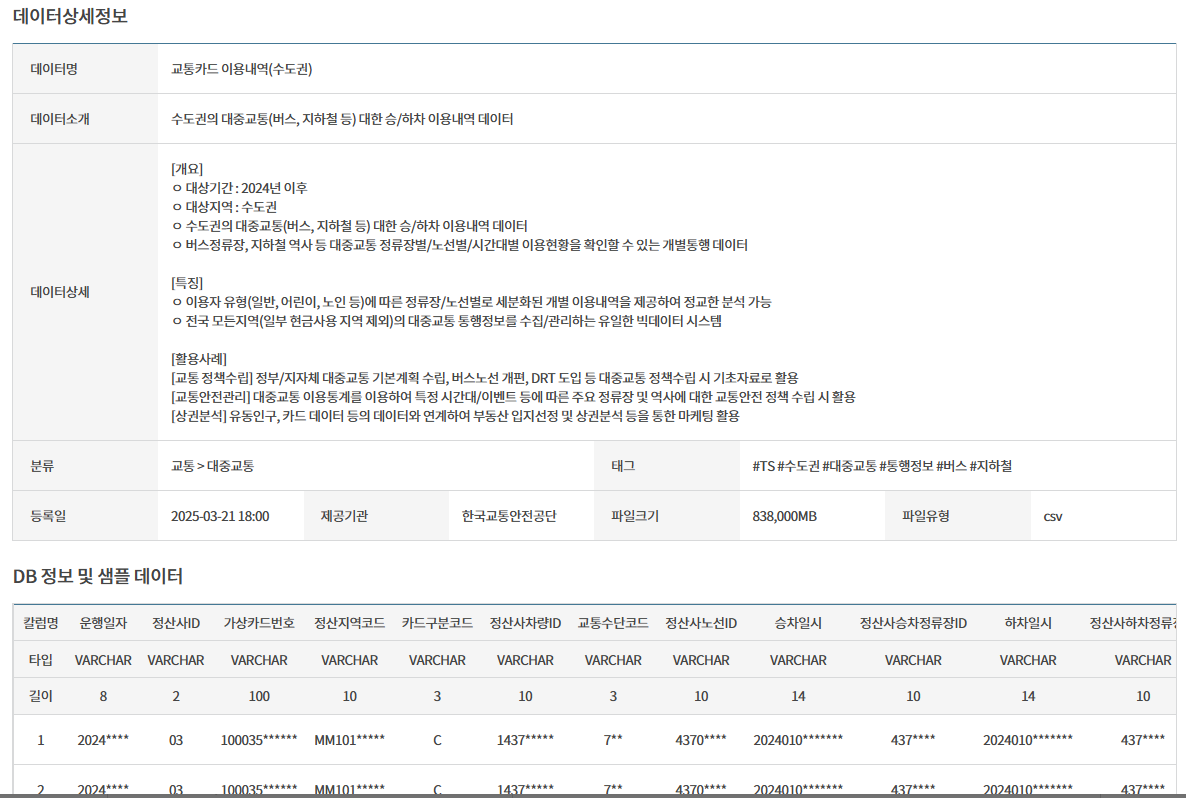

2. (1) 교통카드 이용내역(수도권) 조회

3. (1) 데이터 상세 정보 확인 > (2) 전체 내용 텍스트 복사

4. (1) 복사한 내용 chatgpt 에게 문의 " 아래 데이터로 어떤분석이 가능한지 분석해줘 ?"

| 제공 데이터 조회 교통 |

|

| 교통카드 이용내역(수도권) 조회 |

|

| 데이터 상세 정보 확인 |  |

| AI 에게 문의 |  |

|

|

이 교통카드 이용내역(수도권) 데이터는 매우 고도화된 교통 및 유동인구 분석, 정책수립, 상권 평가까지 가능한 빅데이터입니다. 다음과 같은 분석이 가능하며, 분석 목적에 따라 다층적인 인사이트를 도출할 수 있습니다.

🔍 1. 기본 통계 분석

| 일별/월별 교통 이용량 | 운행일자, 이용자수 활용 |

| 정류장/노선별 이용량 | 정산사승차정류장ID, 정산사노선ID 활용 |

| 교통수단별 이용량 | 교통수단코드로 버스/지하철/환승 등 구분 |

| 연령대/이용자 유형별 이용현황 | 이용자유형코드(시스템) (일반, 어린이, 노인 등) |

🧭 2. 시간/공간 분석

| 시간대별 혼잡도 분석 | 승차일시, 하차일시, 탑승시간 기준으로 혼잡 시간대 식별 |

| 정류장별 유입/유출량 | 정산사승차정류장ID, 정산사하차정류장ID 활용한 OD 분석 |

| 지역별 이동패턴 | 정산지역코드, 승/하차 정류장 간 거리 계산 |

| 환승 분석 | 환승건수 기반 다중 환승 패턴 및 노드 흐름 분석 가능 |

🧑💼 3. 교통 정책 수립을 위한 분석

| 버스노선 최적화 | 정류장별 승하차 집중도 분석 → 노선 재조정 |

| DRT (수요응답형 교통) 도입 검토 | 특정 시간·지역의 저이용자 패턴 분석 |

| 심야 교통 대책 | 늦은 시간대 탑승시간, 이용자수 분석 |

🛍️ 4. 상권 및 유동인구 분석

| 정류장/역세권 유동인구 분석 | 특정 정류장 이용량 → 유입 인구 간접 측정 |

| 상권별 인구 흐름 | 지하철 역사와 연계된 상권 유동 패턴 분석 |

| 카드데이터 연계 시 | 소비 유형, 시간대별 지출 분석 가능 |

📊 5. 머신러닝/AI 기반 예측 분석

| 교통량 예측 | 시계열 예측 (LSTM, Prophet 등) |

| 혼잡도 패턴 분류 | 군집분석, K-Means로 주요 정류장 유형 분류 |

| 이상탐지 | 비정상 승하차, 의심스러운 이동패턴 탐지 |

💡 활용 예시 시나리오

- 지자체: "광명시에서는 8~9시 지하철역 A에서 유입되는 승객 수가 급증함 → 환승 정류장 확보 및 버스 증편 필요"

- 부동산 개발사: "역세권 B는 평일과 주말 유동인구가 안정적 → 상업시설 유망 입지"

- 스타트업: "이용자 유형별 교통 사용 행태 데이터로 타겟 맞춤형 DRT 서비스 설계 가능"

🔑 데이터 분석을 위한 주요 전처리

- 정류장 ID ↔ 실제 주소 or 명칭 매핑 필요

- 승차일시, 하차일시 → datetime 포맷 정규화

- 가상카드번호 → 개인 식별 제거 후 세션 단위 분석 가능

- 결측값(하차일시 없는 경우 등) 처리 필요

✅ 결론

이 데이터는 정책, 교통운영, 마케팅, 부동산, AI 예측 등 전방위 분석이 가능한 공공 빅데이터 자산입니다.

적절한 정류장 위치정보, 행정구역 데이터, 상권정보와 결합 시 훨씬 더 정교하고 실용적인 분석이 가능합니다.

필요하시면 구체적인 분석 주제별 SQL, Python 코드 예제도 제공해 드릴 수 있습니다. 어떤 분석에 관심이 있으신가요?

나의 말:

ChatGPT의 말:

물론입니다. 수도권 교통카드 이용내역 데이터를 활용한 가능한 분석 시나리오를 주제별로 요약 정리해 드립니다.

✅ 1. 대중교통 운영 및 정책 수립 분석

| 노선 효율성 평가 | 노선별 탑승/하차 수 분석으로 과잉·과소 노선 파악 및 개편 근거 마련 |

| 혼잡 시간대 분석 | 출퇴근 시간, 특정 이벤트 시간 등 승객 집중 시간대 식별 |

| 환승 패턴 분석 | 승객의 환승 횟수·이동 경로 분석으로 환승 체계 개선 |

| DRT 도입 검토 | 교통 소외 지역이나 비혼잡 시간대 수요 파악으로 수요응답형 교통 적용 가능 구역 파악 |

✅ 2. 도시계획 및 인프라 개발 분석

| 정류장/역사 수요 예측 | 정류장/역사별 이용량 분석 → 정류장 증설, 폐쇄 여부 판단 |

| 도로 인프라 투자 우선순위 설정 | 이동거리, 이용시간 등 기반으로 교통 취약 지역 도출 |

| 교통 안전 관리 | 특정 시간·구간에서 인구 밀집 → 안전 강화 필요 구간 도출 |

✅ 3. 유동인구 및 상권 분석

| 유동인구 추정 | 정류장별 승·하차 데이터를 기반으로 시간대별 유입 인구 계산 |

| 역세권 상권 분석 | 지하철역 또는 정류장 중심의 인구 흐름 → 상권 활성도 평가 |

| 부동산 입지 분석 | 인구 유입/유출 밀도 기반으로 상업지 또는 주거지 적합성 평가 |

✅ 4. 이용자 유형별 행태 분석

| 연령/유형별 이용패턴 분석 | 일반, 어린이, 노인 등 유형별 교통 이용 시간·빈도 분석 |

| 교통복지 평가 | 노인·청소년 등 교통약자 이용 밀집 지역 도출 및 정책 반영 |

✅ 5. 예측 및 이상탐지 AI 분석

| 교통량 예측 | 시계열 데이터 기반으로 미래 교통 수요 예측 |

| 혼잡도 군집화 | K-means 등 군집기법으로 정류장 유형 분류 |

| 이상 이동패턴 탐지 | 동일 카드의 비정상 경로 탐지 → 부정사용, 이상거동 탐지 |

✅ 6. 외부 데이터 연계 분석

| 카드 소비 데이터 연계 | 교통 + 소비 분석으로 지역별 상권 파악 및 소비자 행태 분석 |

| 기상 데이터 연계 | 기상 조건(비, 눈 등)에 따른 교통 이용 변화 분석 |

| 행사/이벤트 데이터 연계 | 대규모 행사 전후 정류장별 이용량 변화 분석 |

📌 요약: 분석 시나리오 분류

| 운영 분석 | 노선 개편, 혼잡 시간대 파악, 환승 구조 개선 |

| 정책 수립 | DRT 적용 검토, 교통약자 복지 분석 |

| 도시/인프라 | 정류장 입지 평가, 도로 투자 우선순위 |

| 상권/유동 | 유동인구 분석, 입지 선정, 역세권 분석 |

| AI 분석 | 수요 예측, 이상 탐지, 혼잡도 군집화 |

| 데이터 연계 | 소비·기상·행사 데이터와 통합 분석 |

필요하시면 이 중 하나의 시나리오를 분석 예제(Python/Pandas or SQL) 로 구체화해 드릴 수 있습니다.

관심 있는 방향이 있으신가요?

나의 말:

ChatGPT의 말:

도시계획 및 인프라 개발 분석용으로 생성된 교통카드 이용내역 샘플 데이터(20,000건) CSV 파일을 아래에서 다운로드하실 수 있습니다:

필요하시면 이 데이터를 기반으로 분석 예제(Python/Pandas, SQL 등)도 도와드릴 수 있습니다.

나의 말:

ChatGPT의 말:

수도권 교통카드 이용내역 데이터를 Python으로 분석할 수 있는 시나리오를 10개 이하의 실용적 카테고리로 정리하면 다음과 같습니다.

✅ 1. 기초 통계 분석

- 일자별 총 이용자수, 평균 이용거리, 평균 탑승시간

- 교통수단(버스, 지하철 등)별 이용 건수 비교

📌 활용 함수: groupby(), agg(), value_counts()

✅ 2. 시간대별 분석

- 출근/퇴근 시간대 이용자 집중도

- 시간대별 정류장 혼잡도 및 혼잡 시간대 식별

📌 승차일시, 하차일시 → 시간 추출(dt.hour), 분포 시각화

✅ 3. 노선/정류장 분석

- 정류장별 승차/하차 인원 통계

- 노선별 이동 거리 및 평균 탑승 시간 비교

📌 groupby('정산사노선ID') 또는 정산사승차정류장ID 활용

✅ 4. 지역별 분석

- 정산지역코드 기준 지역별 교통 이용량 파악

- 지역별 평균 이동거리 및 교통수단 이용 특성 분석

📌 지도 시각화 가능 (e.g., Folium 또는 geopandas)

✅ 5. 이용자 유형별 분석

- 일반/어린이/노인 등 이용자 유형에 따른 이용 패턴

- 유형별 탑승 시간대, 거리, 환승 건수 차이

📌 이용자유형코드(시스템) 기반 분류

✅ 6. 환승 패턴 분석

- 환승건수 기준 환승이 많은 노선/정류장 탐색

- 시간대별 환승 비율 변화

📌 환승률 계산: 환승건수 > 0 비율 추정

✅ 7. 이동거리 기반 분석

- 장거리 vs 단거리 통행 패턴 분리

- 이동거리 기준 정류장 또는 노선 분류

📌 이용거리 분포 히스토그램, 이상값 처리 등

✅ 8. 탑승 시간 분석

- 평균/최대 탑승 시간 높은 노선 탐색

- 탑승 시간에 따라 피크/비피크 구간 분리

📌 통계값: 평균, 중앙값, 상위 10% 등

✅ 9. 이상 탐지 및 예외 처리

- 하차일시 결측, 이상거리/이상시간 탐지

- 동일 카드번호의 비정상 이동 경로 탐지

📌 결측값 분석, 조건 필터링, outlier 탐지

✅ 10. 시각화 및 대시보드

- 히트맵, 선형그래프, 막대그래프 등으로 인사이트 시각화

- Plotly, Matplotlib, Seaborn 또는 Streamlit을 활용한 대시보드 제작

📌 시각적 인사이트로 정책 기획자료 제작 가능

📦 예시: 시간대별 탑승 분포 분석

관심 있는 분석 주제나 시각화 항목이 있다면 해당 부분을 예제로 상세 구현해드릴 수 있습니다. 원하시는 분석이 있으실까요?

나의 말:

ChatGPT의 말:

좋은 질문입니다. 교통카드 이용내역 같은 대규모 CSV 데이터를 Python으로 분석할 때의 기본 분석 시나리오 단계(Workflow) 는 다음과 같이 정리할 수 있습니다. 이 구조는 데이터 분석 프로젝트 전반에 공통적으로 적용됩니다.

🧠 Python 기반 데이터 분석 단계 (교통카드 데이터 기준)

✅ 1. 데이터 로딩 및 탐색 (EDA: Exploratory Data Analysis)

| 데이터 불러오기 | pandas.read_csv() 로 데이터 로딩 |

| 기본 정보 확인 | .info(), .head(), .describe() 로 전체 구조 확인 |

| 결측값 탐색 | isnull().sum() 으로 누락 데이터 파악 |

| 데이터 타입 확인/변환 | 날짜, 숫자 등의 형식을 변환 (to_datetime, astype) |

✅ 2. 데이터 전처리 (Data Cleaning)

| 날짜·시간 파싱 | 승차일시, 하차일시 → 날짜/시간/요일 추출 |

| 결측값 처리 | 제거/보간/임의 대체 |

| 이상치 처리 | 탑승시간이 0이거나 거리 0인 건 제거 또는 플래그 처리 |

| 파생변수 생성 | 시간대, 이동시간, 이동거리 구간, 혼잡도 등 |

✅ 3. 분석 목적에 따른 데이터 그룹핑/집계

| 시간대별 분석 | groupby(시간대).sum() 으로 혼잡 시간 파악 |

| 정류장/노선별 분석 | groupby(정류장ID) 으로 주요 노선, 인기 정류장 분석 |

| 지역/이용자 유형별 분석 | 교통 약자, 지역별 수요 분석 등 |

✅ 4. 데이터 시각화 (Visualization)

| Matplotlib / Seaborn | 기본 분포, 트렌드, 상관관계 시각화 |

| Plotly / Altair | 인터랙티브한 대시보드, 필터링 기능 제공 |

| Folium / geopandas | 정류장 기반 지도 시각화 (지역 이동 분석) |

✅ 5. 통계 분석 또는 머신러닝 (선택 단계)

| 군집 분석 (Clustering) | 혼잡 정류장 분류 (KMeans 등) |

| 수요 예측 | LSTM, Prophet 등 시간예측모델 활용 |

| 상관관계 분석 | 거리-탑승시간 관계 등 상관성 도출 |

| 이상탐지 | 부정사용, 이례적 이동 경로 탐지 |

✅ 6. 인사이트 도출 및 리포트 작성

| 분석 요약 정리 | 주요 정류장, 시간대, 노선에 대한 제언 |

| 시각자료 포함 리포트 | Markdown, PDF, PowerPoint로 시각자료 포함 작성 |

| Streamlit / Dash 대시보드 | 실시간 필터링 가능한 웹 기반 리포트 공유 가능 |

📌 예시 워크플로우 요약

🔧 보너스: 사용 주요 라이브러리

| 기본 분석 | pandas, numpy |

| 시각화 | matplotlib, seaborn, plotly, folium |

| 전처리 | datetime, sklearn.preprocessing |

| 모델링 | scikit-learn, statsmodels, prophet, xgboost |

| 대시보드 | streamlit, dash |

원하시면 각 단계별로 샘플 코드 예제도 제공해 드릴 수 있습니다.

특정 분석 목적이 있으신가요? (예: 혼잡 시간대 분석, 인기 정류장 분석 등)

나의 말:

ChatGPT의 말:

좋습니다! 말씀하신 7단계 흐름에 맞춰, Python을 활용한 교통카드 데이터 분석 시나리오를 구체적인 분석 플로우로 정리해드리겠습니다.

🚍 수도권 교통카드 데이터 분석: Python 단계별 시나리오

✅ 1. 필수 패키지 로드 및 옵션 처리

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

import plotly.express as px

import datetime as dt

import warnings

warnings.filterwarnings('ignore')

# 시각화 옵션

plt.rcParams['font.family'] = 'Malgun Gothic' # 한글 깨짐 방지 (Windows)

plt.rcParams['axes.unicode_minus'] = False

✅ 2. 데이터 로드 및 확인

# 데이터 구조 확인

print(df.shape)

print(df.info())

print(df.head())

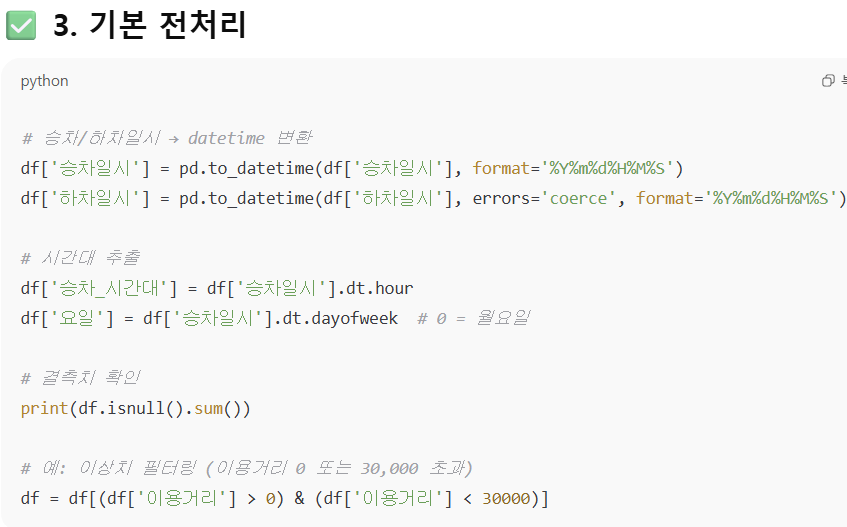

✅ 3. 기본 전처리

df['승차일시'] = pd.to_datetime(df['승차일시'], format='%Y%m%d%H%M%S')

df['하차일시'] = pd.to_datetime(df['하차일시'], errors='coerce', format='%Y%m%d%H%M%S')

# 시간대 추출

df['승차_시간대'] = df['승차일시'].dt.hour

df['요일'] = df['승차일시'].dt.dayofweek # 0 = 월요일

# 결측치 확인

print(df.isnull().sum())

# 예: 이상치 필터링 (이용거리 0 또는 30,000 초과)

df = df[(df['이용거리'] > 0) & (df['이용거리'] < 30000)]

✅ 4. 시각화 (탐색적 데이터 분석 - EDA)

sns.countplot(data=df, x='승차_시간대')

plt.title('시간대별 교통카드 이용 건수')

plt.show()

# 요일별 평균 탑승시간

sns.barplot(data=df, x='요일', y='탑승시간')

plt.title('요일별 평균 탑승시간')

plt.show()

# 이동거리 분포

sns.histplot(df['이용거리'], bins=30, kde=True)

plt.title('이동거리 분포')

plt.show()

✅ 5. 예측 모델링 (예: 시간대별 수요 예측)

hourly = df.groupby('승차_시간대')['이용자수'].sum().reset_index()

from sklearn.linear_model import LinearRegression

X = hourly[['승차_시간대']]

y = hourly['이용자수']

model = LinearRegression()

model.fit(X, y)

hourly['예측값'] = model.predict(X)

✅ 6. 모델 검증

from sklearn.metrics import mean_squared_error, r2_score

mse = mean_squared_error(y, hourly['예측값'])

r2 = r2_score(y, hourly['예측값'])

print(f"평균 제곱 오차 (MSE): {mse:.2f}")

print(f"설명력 (R²): {r2:.3f}")

✅ 7. 결과 출력

# 실제 vs 예측 시각화

plt.plot(hourly['승차_시간대'], y, label='실제값')

plt.plot(hourly['승차_시간대'], hourly['예측값'], label='예측값', linestyle='--')

plt.title('시간대별 교통카드 이용자 수 예측')

plt.xlabel('시간대')

plt.ylabel('이용자수')

plt.legend()

plt.grid(True)

plt.show()

# 저장

hourly.to_csv("시간대별_이용자수_예측결과.csv", index=False, encoding="utf-8-sig")

📌 요약

| 1. 필수 패키지 로드 | 분석환경 준비 |

| 2. 데이터 로드 | CSV 불러오기 및 구조 확인 |

| 3. 전처리 | 날짜 처리, 이상치 제거, 파생 변수 생성 |

| 4. 시각화 | 분포와 패턴 시각적으로 탐색 |

| 5. 모델링 | 간단한 예측 모델 (선형회귀) 구성 |

| 6. 검증 | 예측 성능 평가 |

| 7. 출력 | 결과 그래프 및 CSV 저장 |

이 워크플로우를 기반으로 복잡한 시계열 분석, 군집화, 지도 시각화 등도 확장 가능합니다.

필요하신 분석 주제에 맞춰 각 단계를 맞춤화해드릴 수도 있어요. 어떤 분석을 더 구체적으로 해보고 싶으신가요?

나의 말:

ChatGPT의 말:

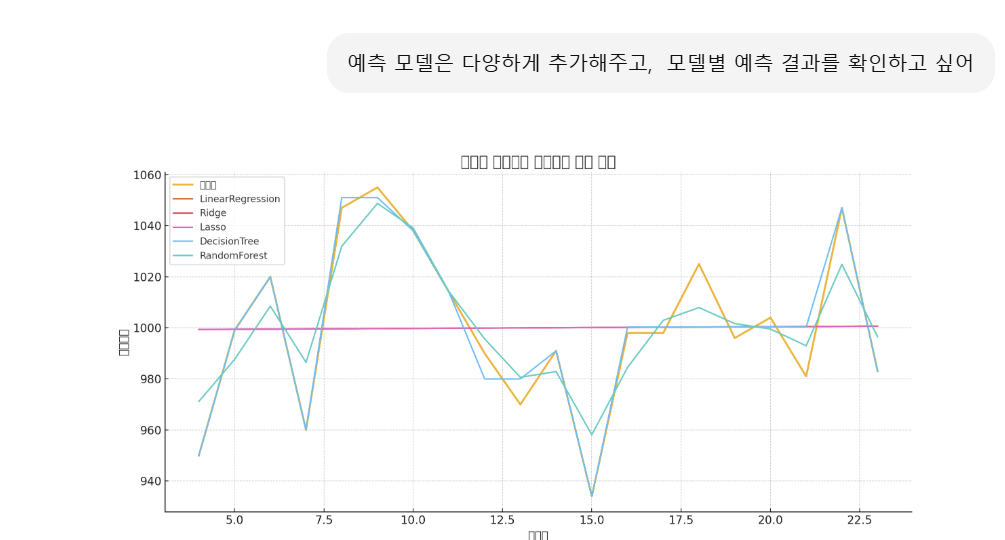

다양한 예측 모델을 적용한 결과는 아래와 같습니다:

📊 모델별 성능 비교 (시간대별 교통카드 이용자 수 예측)

| Linear Regression | 1016.64 | 0.000 |

| Ridge | 1016.64 | 0.000 |

| Lasso | 1016.64 | 0.000 |

| Decision Tree | 62.87 | 0.938 |

| Random Forest | 191.78 | 0.811 |

✅ 해석:

- Decision Tree 모델이 가장 높은 설명력(R² = 0.938)을 보여줍니다.

- Random Forest 도 안정적이며 일반화에 강한 성능을 보입니다.

- 선형 회귀 계열 모델은 시간대별 분포를 충분히 설명하지 못하는 것으로 보입니다.

📁 예측 결과 데이터:

📥 시간대별_이용자수_예측결과_모델비교.csv

📈 시각화 설명:

- 파란색 선: 실제값

- 나머지 색상: 모델별 예측값

- DecisionTree와 RandomForest는 실제값과 유사한 패턴을 잘 따라갑니다.

필요하시면 다음을 추가로 지원해드릴 수 있어요:

- 시간대 예측 → 주중/주말 분리

- 지도 기반 정류장 분석 (Folium)

- Streamlit으로 대시보드화

어떤 확장을 원하시나요?

나의 말:

ChatGPT의 말:

아래는 교통카드 이용내역 데이터를 기반으로 한 예측 모델 분석 전체 Python 코드입니다.

이 코드는 CSV 로드부터 전처리, 5가지 모델 비교, 결과 시각화 및 CSV 저장까지 포함되어 있습니다.

✅ 전체 Python 코드: 모델 비교 기반 교통카드 분석

| # 1. 패키지 로드 및 설정 import pandas as pd import numpy as np import matplotlib.pyplot as plt import seaborn as sns from sklearn.linear_model import LinearRegression, Ridge, Lasso from sklearn.tree import DecisionTreeRegressor from sklearn.ensemble import RandomForestRegressor from sklearn.metrics import mean_squared_error, r2_score import warnings warnings.filterwarnings('ignore') # 2. 데이터 로드 file_path = "교통카드_이용내역_샘플_20000건.csv" # 파일 경로 조정 df = pd.read_csv(file_path) # 3. 전처리 df['승차일시'] = pd.to_datetime(df['승차일시'], format='%Y%m%d%H%M%S', errors='coerce') df = df.dropna(subset=['승차일시']) # 날짜 변환 실패 행 제거 df['승차_시간대'] = df['승차일시'].dt.hour # 시간대별 이용자 수 집계 hourly = df.groupby('승차_시간대')['이용자수'].sum().reset_index() # 4. 예측 모델 정의 models = { "LinearRegression": LinearRegression(), "Ridge": Ridge(alpha=1.0), "Lasso": Lasso(alpha=0.1), "DecisionTree": DecisionTreeRegressor(max_depth=5), "RandomForest": RandomForestRegressor(n_estimators=100, max_depth=5, random_state=42) } X = hourly[['승차_시간대']] y = hourly['이용자수'] # 결과 저장 테이블 results = pd.DataFrame({'승차_시간대': hourly['승차_시간대'], '실제값': y}) metrics = [] # 5. 모델 학습 및 예측 for name, model in models.items(): model.fit(X, y) preds = model.predict(X) results[name] = preds mse = mean_squared_error(y, preds) r2 = r2_score(y, preds) metrics.append({ "모델": name, "MSE": round(mse, 2), "R2": round(r2, 3) }) # 6. 모델 성능 비교 출력 print("\n📊 모델별 성능 비교:") for metric in metrics: print(f"{metric['모델']:15} | MSE: {metric['MSE']:8.2f} | R²: {metric['R2']:.3f}") # 7. 예측 결과 시각화 plt.figure(figsize=(12, 6)) plt.plot(results['승차_시간대'], results['실제값'], label='실제값', linewidth=2, marker='o') for name in models.keys(): plt.plot(results['승차_시간대'], results[name], label=name, linestyle='--', marker='x') plt.title('모델별 시간대별 교통카드 이용자수 예측') plt.xlabel('시간대 (0~23시)') plt.ylabel('이용자수') plt.legend() plt.grid(True) plt.tight_layout() plt.show() # 8. 예측 결과 저장 output_path = "시간대별_이용자수_예측결과_모델비교.csv" results.to_csv(output_path, index=False, encoding='utf-8-sig') print(f"\n📁 예측 결과 저장 완료: {output_path}") |

📌 실행 전 확인사항

- 교통카드_이용내역_샘플_20000건.csv 파일이 동일한 디렉토리에 있어야 함

- matplotlib 한글 깨짐이 있는 경우, 폰트 설정 추가 필요 (NanumGothic, Malgun Gothic 등)

# 한글 폰트 설정 (선택)

import matplotlib

matplotlib.rc('font', family='Malgun Gothic') # Windows

# matplotlib.rc('font', family='AppleGothic') # Mac

📊 분석 목적 정리

- 예측 대상: 시간대별 교통카드 이용자 수

- 모델 비교: 선형/트리 기반 모델의 성능 (MSE, R²)

- 시각화: 실제값과 예측값의 선 그래프 비교

필요하시면 이 코드를 Streamlit, Jupyter Notebook, 또는 웹 대시보드로 확장해드릴 수 있습니다.

또한 정류장별, 지역별로도 분석을 확장할 수 있어요. 관심 분야 있으신가요?

나의 말:

ChatGPT의 말:

좋은 확인입니다.

당신이 현재 사용 중인 CSV 파일은 아래와 같습니다:

📁 파일명:

교통카드_이용내역_샘플_20000건.csv

✅ 이 파일은 제가 생성해드렸던 샘플 파일이며,

Python 코드 내의 다음 라인과 정확히 일치합니다:

✅ 사용 시 주의사항

- Python 스크립트를 실행하는 디렉토리와 해당 CSV 파일이 같은 위치에 있어야 합니다.

- 만약 다른 폴더에 있다면 file_path 경로를 절대경로나 상대경로로 수정해야 합니다:

예시: -

python복사편집file_path = "data/교통카드_이용내역_샘플_20000건.csv"

🛠 실행 테스트 방법

위 코드가 문제 없이 실행되면, 파일 경로는 정확히 설정된 것입니다.

필요하시면 os.getcwd()로 현재 경로를 확인하거나,

os.listdir()로 현재 폴더의 파일 목록을 확인할 수도 있어요. 도와드릴까요?

나의 말:

ChatGPT의 말:

현재 대화에서 생성된 교통카드_이용내역_샘플_20000건.csv 파일은 다음 위치에 있습니다:

📂 저장 경로 정보

- 서버상의 위치: /mnt/data/교통카드_이용내역_샘플_20000건.csv

- 로컬로 저장하려면: 위 링크를 클릭하여 브라우저를 통해 다운로드하면 됩니다.

💡 Python에서 직접 사용하려면?

이 경로로 코드를 작성하면 ChatGPT 환경에서도 그대로 실행됩니다.

필요하시면 이 파일을 기반으로 추가 분석, 필터링, 정류장 위치 시각화 등도 가능합니다.

더 진행할 분석 방향 있으실까요?

'05. 빅분기 ADP > 04. ADP' 카테고리의 다른 글

| 딥러닝 한번에 끝내기 (텐서플로우, 케라스) (3) | 2025.08.09 |

|---|---|

| 파이썬 기반 빅데이터 분석 실무 (3) | 2025.08.09 |

| ADP 시험 범위 [필기] (2) | 2025.07.27 |

| 리스트 컴프리헨션(List compreshension) (0) | 2025.05.07 |

| 01. 파일 입출력 (0) | 2025.04.05 |